De l'esquisse au chef-d'œuvre , Le workflow ControlNet expliqué en détail

ControlNet permet d’imposer la composition, la pose ou la profondeur à l’IA. Guide des préprocesseurs, réglages et workflows pour des rendus maîtrisés.

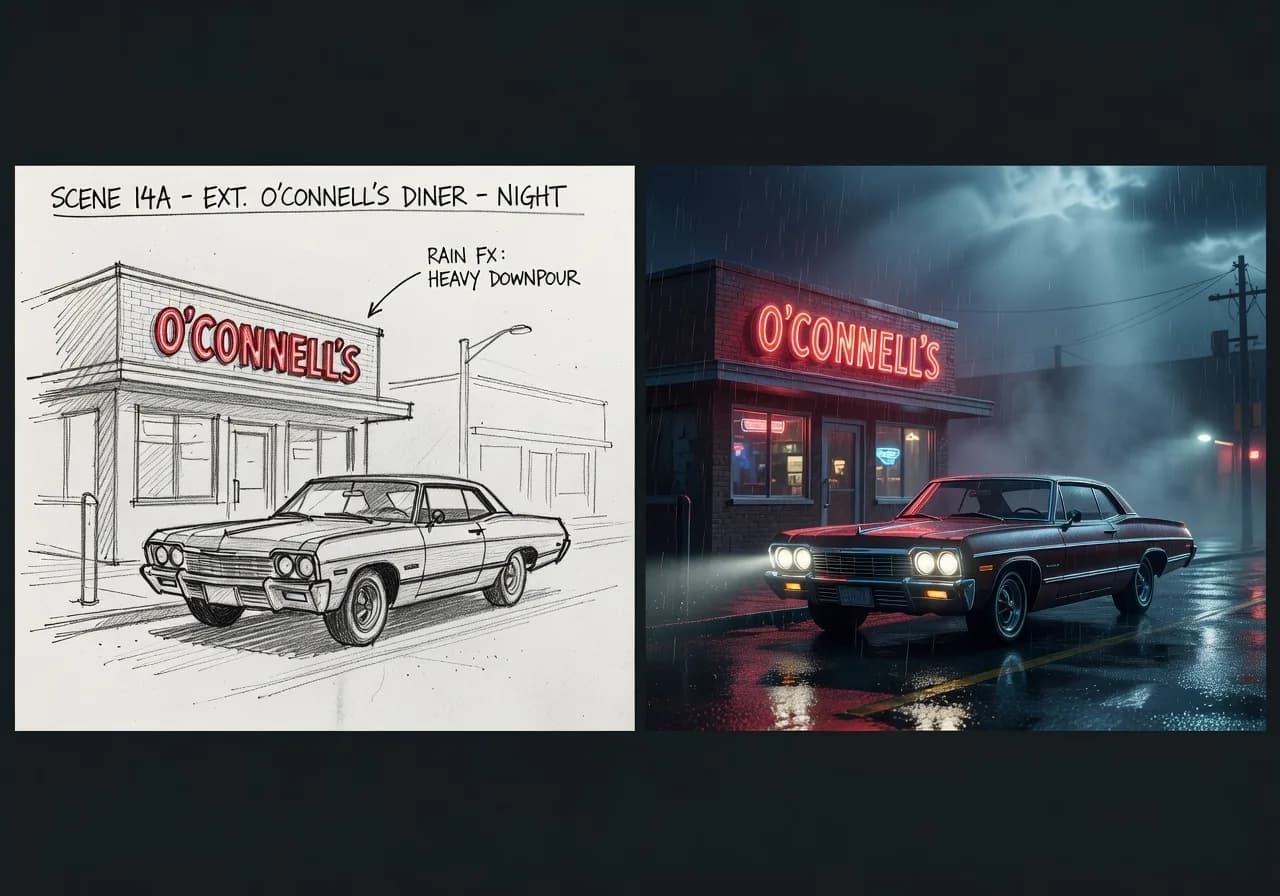

Tu as une esquisse, un storyboard, une photo dont tu veux garder exactement la composition mais changer le style ou le sujet. Sans outil, tu décris tout en texte et tu croises les doigts. Avec ControlNet, tu donnes à l’IA une carte : contours (canny), profondeur (depth), pose (openpose), etc. Le modèle remplit la forme en respectant ta structure. C’est le chaînon manquant entre la main du directeur artistique et le rendu final. Ce guide détaille les préprocesseurs, les réglages et un workflow pas à pas pour passer de l’esquisse au chef-d’œuvre sans perdre le contrôle.

À quoi sert ControlNet (en une phrase)

ControlNet est un réseau de contrôle qui s’ajoute à un modèle de diffusion (souvent Stable Diffusion). Il prend une image d’entrée, en extrait une représentation (contours, profondeur, pose, etc.), et conditionne la génération pour que la sortie respecte cette structure. Tu gardes donc la composition ou la pose de ton esquisse tout en laissant le modèle générer les couleurs, les textures et le style à partir de ton prompt. Pour comprendre comment l’IA combine image et texte, l’analyse du poids des références visuelles complète bien ce workflow.

Les préprocesseurs utiles (et quand les utiliser)

| Préprocesseur | Entrée | Sortie utilisée par ControlNet | Cas d’usage |

|---|---|---|---|

| Canny | Image (photo, dessin) | Contours (edges) | Reproduire la composition et les lignes ; esquisse au trait → rendu peinture ou photo |

| Depth | Image | Carte de profondeur (avant/arrière-plan) | Garder la profondeur de scène ; changer le style ou l’époque |

| OpenPose | Image (personne) | Squelette (pose) | Garder la pose exacte ; changer le personnage, le costume, le décor |

| Lineart | Image | Lignes épurées | Proche de Canny, utile pour dessins ou storyboards très lisibles |

| Tile | Image | Détails locaux (texture) | Réutiliser les détails d’une zone sans imposer la composition globale |

En pratique.

- Esquisse → rendu réaliste ou stylisé : Canny ou Lineart. Tu dessines (ou tu scannes) les contours ; le prompt décrit le style (cinéma, peinture, etc.).

- Photo → même composition, autre style : Depth ou Canny. La photo donne la structure ; le prompt décrit « film noir des années 40 » ou « illustration flat ».

- Même pose, autre personnage / décor : OpenPose. Une photo de référence donne la pose ; le prompt décrit le nouveau sujet et la scène.

Pour des portraits avec une pose précise (Rembrandt, butterfly), le portrait IA studio et les plans d’éclairage s’appuient souvent sur OpenPose + un prompt lumière très précis.

Workflow en 6 étapes (Stable Diffusion + ControlNet)

-

Préparer l’image d’entrée.

Esquisse : contraste net, fond simple si possible. Photo : si tu utilises Depth ou Canny, une image déjà bien composée donne de meilleurs résultats. Pour OpenPose, une photo avec la pose claire (personne visible en entier ou au moins torse + bras). -

Choisir le préprocesseur.

Canny pour les contours ; Depth pour la profondeur ; OpenPose pour la pose. Un seul ControlNet à la fois pour commencer (certaines interfaces permettent d’en chaîner plusieurs). -

Préprocesser.

Dans l’interface (ComfyUI, A1111, etc.), lance le préprocesseur sur ton image. Tu obtiens une carte (edges, depth map, skeleton). Vérifie que la carte est lisible (pas tout noir ou tout blanc). -

Rédiger le prompt.

Décris le rendu que tu veux : sujet, lumière, style, ambiance. Pas besoin de redécrire la composition , ControlNet s’en charge. Ex. : « Woman in red dress, soft key light from left, 35mm, cinematic stills, cinema photography, film grain. » Pour garder une structure de directeur artistique, garde l’ordre : sujet → cadrage → lumière → technique. -

Régler le poids (strength) de ControlNet.

Souvent entre 0.5 et 1.0. À 1.0, la sortie colle très fort à l’esquisse (parfois trop rigide). À 0.5–0.7, le modèle a plus de liberté pour adoucir les lignes ou ajuster les détails. Itérer selon le résultat. -

Générer et itérer.

Lance la génération. Si la structure est trop respectée (rendu « dessiné »), baisse le poids. Si la composition dérive, monte le poids ou améliore l’esquisse (contours plus nets).

ControlNet ne devine pas ton intention. Il suit la carte que tu lui donnes. Plus ta carte est claire, plus le rendu est prévisible.

Scénarios concrets

Scénario 1 , Storyboard → visuels de préproduction.

Tu as des cases dessinées à la main (personnages, cadrage). Workflow : Scanner ou photographier les cases. Préprocesseur Canny ou Lineart. Prompt par image : décrire le style (ex. « cinematic stills, 35mm, film noir, rain »). Poids ControlNet 0.7–0.9. Tu obtiens des visuels « finaux » qui respectent tes cadrages pour le moodboard ou la préproduction.

Scénario 2 , Photo de repérage → concept art.

Tu as une photo de lieu (rue, forêt). Tu veux la même composition en peinture ou en style film. Workflow : Depth pour garder les plans (avant / arrière). Prompt : « Same composition, [style], cinematic stills, cinema photography, moody lighting ». Poids 0.6–0.8. La scène garde sa structure, seul le rendu change.

Scénario 3 , Pose de référence → nouveau personnage.

Tu as une photo d’un mannequin dans une pose précise. Tu veux la même pose avec un autre visage, un autre costume. Workflow : OpenPose. Prompt : « [Description du nouveau personnage], [costume], [décor], soft key from left, 85mm, cinematic stills ». Poids 0.8–1.0. Pour la régularité du visage sur plusieurs images, OpenPose + character reference ou LoRA peut être combiné selon l’outil.

Ce que les débutants se trompent

Esquisse trop vague ou trop brouillon.

Si les contours sont illisibles, ControlNet transmet le flou. Correction : Contraste élevé, lignes nettes. Redessiner les traits importants au propre si besoin.

Poids à 1.0 tout le temps.

Résultat souvent trop « collé » à l’esquisse, peu de vie. Correction : Tester 0.6, 0.75, 0.9. Laisser le modèle adoucir ou interpréter un peu.

Prompt qui décrit la composition.

« Woman on the left, tree on the right » alors que l’esquisse impose déjà la composition. Correction : Décrire uniquement le style, la lumière, le sujet (qui/quoi), pas la position dans le cadre , ControlNet gère la structure.

Mauvais préprocesseur pour l’objectif.

Utiliser Canny pour « garder la pose » : Canny donne les contours, pas la pose. Correction : Pose → OpenPose. Composition / contours → Canny ou Lineart. Profondeur → Depth.

Oublier le negative prompt.

Sur Stable Diffusion, un negative prompt (« blurry, deformed, extra fingers ») évite des artefacts. Pour les pièges courants et les aberrations, un article dédié liste les formulations utiles.

| Problème | Piste de solution |

|---|---|

| Rendu trop fidèle à l’esquisse (rigide) | Baisser le poids ControlNet (0.5–0.7). |

| La composition dérive | Monter le poids ; vérifier que la carte (canny/depth/pose) est bien extraite. |

| Artefacts (mains, visage) | Negative prompt ; ou régénérer ; ou post-traitement. |

| Carte toute noire ou blanche | Ajuster le seuil du préprocesseur ou le contraste de l’image d’entrée. |

Intégration dans une chaîne pro

ControlNet s’insère après la conception (esquisse, storyboard, photo de ref) et avant la validation du rendu. Pour des visuels publicitaires cohérents, tu peux fixer une style reference (--sref ou équivalent) en plus de ControlNet pour garder la même lumière et la même palette sur toute la série, tout en imposant la composition image par image. Pour l’éclairage cinématographique, le prompt reste le levier principal une fois la structure verrouillée par ControlNet.

Ressource vidéo : Pour voir un workflow complet « esquisse → ControlNet → rendu » (Canny, Depth, OpenPose), cherchez sur YouTube « ControlNet tutorial Stable Diffusion » ou « ControlNet canny depth openpose ».

Questions fréquentes (FAQ)

ControlNet est-il disponible sur Midjourney ou Flux ?

Midjourney et Flux (grand public) n’intègrent pas ControlNet. ControlNet est disponible avec Stable Diffusion (ComfyUI, Automatic1111, etc.). Certains outils en ligne (Runway, etc.) proposent des options « structure from image » qui s’en rapprochent.

Peut-on utiliser deux ControlNet en même temps ?

Oui, sur des interfaces comme ComfyUI : par ex. Depth + OpenPose pour garder à la fois la profondeur de scène et la pose d’un personnage. Ça demande un peu de réglage pour doser les deux poids.

Mon esquisse est en couleur. Ça pose problème ?

Les préprocesseurs Canny, Lineart et Depth convertissent l’image en carte (contours, profondeur). La couleur de l’esquisse n’est en général pas utilisée ; seules la structure et les valeurs comptent. Une esquisse en noir et blanc suffit.

OpenPose ne détecte pas bien la pose.

Utiliser une photo avec la personne bien visible (pas coupée, pas de bras cachés). Certains préprocesseurs proposent des options « hand » ou « face » pour affiner. Si la pose est complexe, simplifier l’image (fond neutre) pour que le détecteur se concentre sur le corps.

Quelle résolution pour l’image d’entrée ?

Une résolution raisonnable (1024 px ou plus en largeur) donne de bonnes cartes. Trop petite, les détails sont perdus ; trop grande, le préprocesseur peut être plus lent. Adapter au modèle (ex. SDXL : 1024x1024 ou ratio choisi).

ControlNet ralentit-il beaucoup la génération ?

Oui, un peu. Le préprocesseur tourne une fois ; le modèle de diffusion est conditionné à chaque step. Sur GPU correcte, ça reste utilisable en itération. Pour du batch, prévoir des temps de calcul plus longs.

Frank Houbre - expert IA vidéo et Image

Frank Houbre est un expert en IA vidéo et image, artiste IA et filmmaker récompensé aux Seoul International AI Film Festival et aux Mondial Chroma Awards. Avec plus de 10 ans d'expérience en entrepreneuriat digital, il crée des courts-métrages et animés entièrement générés par IA (Midjourney, Kling, Adobe Firefly). Co-Fondateur de Screenweaver et de la communauté #AIStudios, il partage des tutoriels gratuits et avis d'outils sur Business Dynamite pour aider les créateurs à automatiser leur production.

Continuer la lecture

- Analyse d'image , Comment l'IA interprète le poids des références visuelles

Image reference, style reference, ControlNet : comprendre comment le moteur combine ton image et ton texte pour ne plus avoir de surprises.

- Génération d'images par lots (Batch prompting) pour les agences de publicité

Produire des dizaines de visuels cohérents pour une campagne : structure des prompts, variables, style reference et pipelines pour les agences.

- Forcer la composition mathématique (Nombre d'or, Tiers) dans l'IA visuelle

Imposer la règle des tiers, le nombre d’or ou une composition précise en prompt : ce qui marche, ce qui ne marche pas, et les contournements.